Начало лета 2024 года потрясло всех, кто связан с разработкой и продвижением сайтов. Произошла самая масштабная утечка данных об алгоритмах ранжирования Google за 15 лет. Многие помнят крупную утечку данных в 2023 году, которая произошла во время разбирательства по антимонопольному иску против компании. Некоторые данные из последней утечки подтверждают правдивость информации из предыдущей.

Что произошло и какие данные слили

В воскресенье, 5 мая, Рэнд Фишкин (англ. Rand Fishkin), в прошлом SEO-специалист, а сейчас автор блога SparkToro, получил электронное письмо от человека, утверждающего, что у него есть доступ к утекшей документации API из отдела поиска Google. В электронном письме также утверждалось, что подлинность этих просочившихся документов подтвердили бывшие сотрудники Google, и что они и другие лица поделились дополнительной информацией о работе поиска Гугла. В письме содержалась ссылка на общедоступный репозиторий на GitHub. Рэнд был шокирован этой информацией, так как многое из перечисленного противоречило официальным заявлениям Google, поэтому продолжил задавать вопросы источнику.

24 мая, после нескольких писем Рэнд Фишкин проводит видеозвонок с анонимным источником с целью убедиться в правдивости информации. 28 мая источник решил раскрыть свою личность. Таким образом, Эрфан Азими (англ. Erfan Azimi), SEO-специалист и основатель компании EA Eagle Digital, выступил с заявлением, которое опубликовал на YouTube.

В видео Эрфан Азими утверждает:

- Документы были переданы Рэнду Фишкину с целью раскрыть несоответствия в официальных заявлениях Google;

- Ответы сотрудников Google об использовании данных о поисковых запросах и кликах подтверждают, что компания может вводить в заблуждение относительно работы алгоритмов;

- Цель Эрфана Азими — рассказать правдивую информацию вебмастерам и владельцам бизнесов для оптимизации их сайтов под поисковую систему.

Почему данные считают настоящими

Похоже, что документация по ошибке попала в общедоступный репозиторий на GitHub, принадлежащий Google. Утечка произошла еще 13 марта 2024 года, и данные слил собственный автоматизированный инструмент компании, который случайно снабдил коммит опенсорсной лицензий Apache 2.0 — это стандарт для публичной документации компании. В последующем коммите от 7 мая 2024 года была предпринята попытка устранить эту утечку.

Что содержится в слитых данных

Слитые документы относятся к старой версии API для работы с контентом поиска Google. В этих документах нет программного кода, они просто объясняют, как использовать API, который, по всей видимости, был создан для внутренних нужд поисковика. В документах также упоминаются многочисленные внутренние системы и проекты компании. Хотя похожий API от Google Cloud уже доступен публично, информация, опубликованная на GitHub, раскрывает гораздо больше интересных подробностей, потому что слитые файлы содержат критерии, которые Google считает ключевыми для ранжирования сайтов в поиске.

В документации на 2500 страницах описано более 14 000 атрибутов, связанных с API. Однако в файлах мало информации о том, как эти атрибуты используются и какое значение они имеют. Поэтому пока сложно определить, какое влияние разные атрибуты оказывают на алгоритм ранжирования результатов поиска Google.

Что важного для продвижения сайтов есть в утекших данных

Итак, какую информацию из утекших данных мы должны знать как SEO-специалисты.

Twiddlers

Twiddlers — это модули переранжирования, которые активируются после основного алгоритма поиска Ascorer. Twiddlers и NavBoost применяются на этапе окончательного ранжирования документов. Они корректируют результаты поиска на основе пользовательских взаимодействий, помогают улучшить разнообразие и релевантность результатов поиска. Twiddlers повторно оценивают релевантность документа или порядок его размещения в выдаче.

Фишкин в своей публикации приводит такой пример: если многие пользователи ищут «Рэнд Фишкин», не находят SparkToro, а затем меняют свой запрос на «SparkToro» и кликают на SparkToro.com, сайт получит повышение в результатах поиска по ключевому слову «Рэнд Фишкин».

Многие известные системы и эксперименты в реальном времени реализованы именно так. Как показывает пример бывшего сотрудника Google, твиддлеры играют важную роль в различных системах Google:

В твите описывается ситуация, когда Deedy изменил определение API для "superroot" — сервиса, на котором работает поиск Google, отключив "twiddlers". Это неожиданно повлияло на поиск YouTube и привело к его отключению на несколько часов.

Текст на изображении: Deedy (@deedydas) "Однажды я изменил определение API для superroot, сервиса, на котором работает поиск Google, чтобы отключить "twiddlers", не осознавая, что поиск YouTube полностью зависит от них, и я вывел из строя поиск YouTube на несколько часов."

Twiddlers также могут налагать ограничения по категориям. Таким образом соблюдается разнообразие результатов в выдаче. Например, в выдаче разрешено показывать только три поста одного блога.

Предполагается, что все функции с суффиксом Boost работают на основе фреймворка Twiddler. В документации упоминаются такие Boosts:

- NavBoost

- QualityBoost

- RealTimeBoost

- WebImageBoost

Важность кликов

Этот пункт вытекает из предыдущего. В документации упоминают такие функции как «goodClicks», «badClicks», «lastLongestClicks». Они связаны с NavBoost — это система ранжирования, использующая показатели кликов для повышения или понижения рейтинга в поиске. Она существует примерно с 2005 года и использует данные о кликах за 13 месяцев. Система ориентирована на результаты веб-поиска и считается одним из самых сильных сигналов ранжирования Гугла.

В утечке документов 84 раза упоминается показатель "NavBoost". Таким образом мы понимаем, что клики пользователей и поведение после кликов — неотъемлемая часть алгоритмов ранжирования Google.

Google использует NavBoost для анализа данных о кликах, включая:

- Количество кликов по результатам поиска;

- Длительность кликов. Длинные клики — это те, после которых пользователь не уходит с сайта и продолжает работу с ним. Короткие — наоборот, говорят о том, что пользователь недоволен результатом выдачи;

- Вовлеченность пользователей. Это сохранения в закладки, репосты публикаций, переходы на другие страницы сайта и прочие действия.

Эти данные нужны Google, чтобы определять тенденции поискового спроса и оценивать общее качество сайта. Поисковик использует не все клики, а только те, которые считает важными.

Использование данных из Chrome для ранжирования

Было много разговоров о том, что Гугл использует данные с панелей инструментов и других данных. На момент написания статьи поисковик все еще не прокомментировал произошедшую утечку. Но давайте вспомним, как Мэтт Каттс (англ. Matt Cutts), бывший руководитель команды по борьбе с поисковым спамом Google, в разговоре с Биллом Харцером однозначно заявлял, что:

«Органический алгоритм Google не использует данные Google Chrome. То же самое касается и панели инструментов Google.»

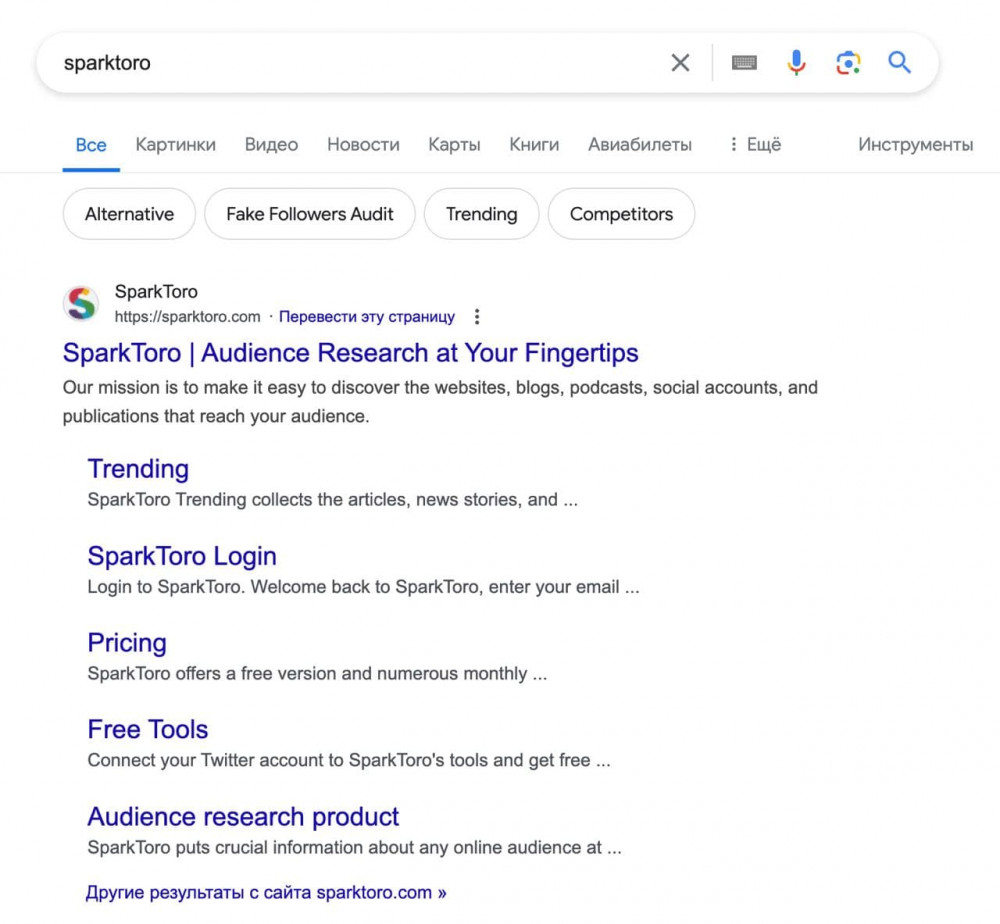

Данные из 2500 слитых документов опровергают это заявление. Даже после официального заявления 12 лет назад, не все СЕОшники поверили.

Автор комментария считает, что Мэтту нельзя верить и он сам не знает, что происходит в его собственной и других командах Google. А если вы не хотите передавать данные о своих действиях в интернете, поставьте другой браузер, например, Firefox.

Google использует данные из Chrome для того, чтобы определить, какие ссылки выводить в выдаче в качестве дополнительных. По словам источника, компания еще в 2005 году планировала использовать клики в ранжировании, и Chrome помог в этом.

Чем больше посетители сайта, используя Chrome, кликают по определенным страницам сайта, тем больше вероятность, что ссылки на эти страницы попадут в сниппет. Данные рассчитываются и по отдельным страницам, и по доменам.

Клики для расчета веса, передаваемого через ссылки

Google также использует данные о кликах для определения веса ссылок при ранжировании, разделяя их на низкие, средние и высококачественные в зависимости от вовлеченности пользователей. Как это работает: если определенная ссылка на сайте не получает кликов, в контексте веса она игнорируется, но если переходов много, она начнет передавать сигналы ранжирования.

Авторитет домена

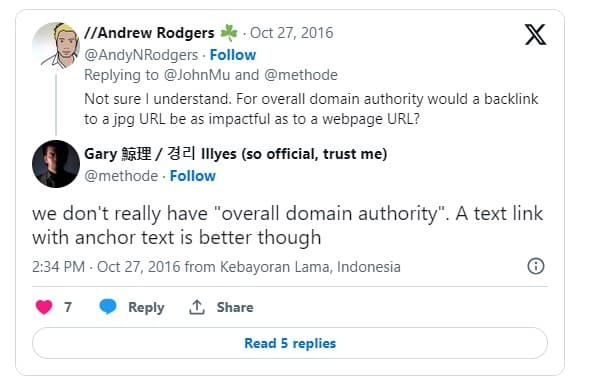

Compressed Quality Signals — это группа факторов, влияющих на ранжирование. В их рамках может быть рассчитан показатель siteAuthority. Гарри Илш (англ. Gary Illyes), аналитик команды поиска Google, многократно говорил, что ничего подобного нет. Например, он сказал это в Twitter в ответ на вопрос о ссылках на изображения и заявил, что в алгоритмах Google нет понятия авторитета домена.

Представители Google неоднократно заявляли, что не используют "domain authority". Однако утечка документов показывает, что Google считывает характеристику под названием "siteAuthority" как часть усредненных сигналов качества, то есть Compressed Quality Signals, составленных на основе каждого документа. Точный расчет siteAuthority и использование в последующих оценках качества сайта неясны. Зато теперь точно известно, что у Google есть общая метрика авторитетности домена — это противоречит их публичным заявлениям.

Песочница

Термин «Песочница» обозначает фильтр поисковых систем, предположительно применяемый к новым сайтам, чтобы они не появлялись в топе сразу. Считается, что новому сайту нужно «отсидеться» некоторое время, прежде чем он сможет попасть на высокие позиции в выдаче.

Миф о «Песочнице» возник в 2004-2005 годах. Несмотря на опровержения со стороны Google, некоторые оптимизаторы продолжали верить в его существование, основываясь на собственном опыте — и оказались правы. Они советуют развивать сайт, улучшать качество контента и ссылочной массы, что в конечном итоге привлечет внимание поисковика. Срок выхода из песочницы, по мнению некоторых, может достигать года.

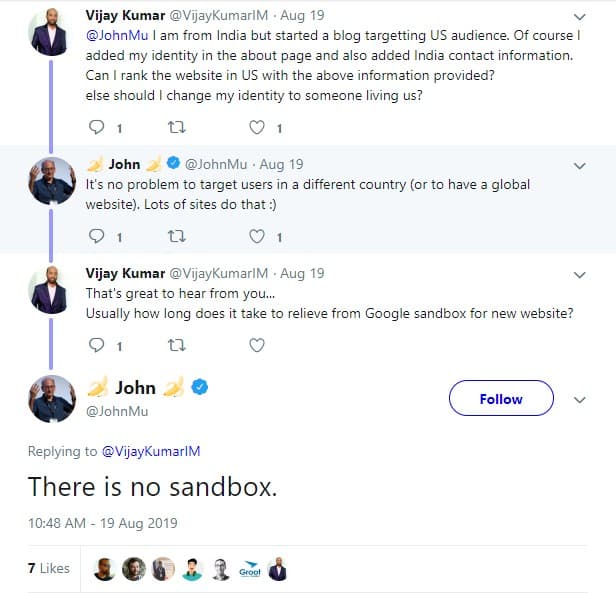

Гарри Илш в 2016 году в Twitter написал, что у поисковика нет «Песочницы». Джон Мюллер также утверждал, что нет никаких ограничений по возрасту сайта для того, чтобы страницы попали в топ выдачи. Он подчеркнул, что:

«Множество факторов влияет на сканирование, индексацию и ранжирование контента. Таким образом, иногда новая страница может оказаться важной для поисковика и занять высокие позиции в выдаче.»

По слитой информации очевидно, что отдельная песочница для новых сайтов есть, но Гугл всегда это отрицал. Здесь Джон Мюллер (англ. John Mueller), эксперт Google по поисковым системам, также говорит, что «Песочницы» нет:

Важность ключа в урле

Наличие главного ключевого слова в домене действительно важно, а также название поддомена. Об этом говорится, например, в последнем исследовании факторов ранжирования от Semrush.

Слова в ссылках должны перекликаться с контентом. Тогда поисковики будут знать, какой контент находится на конкретных страницах. Добавляйте ключи в URL, и на такие страницы будут охотнее заходить пользователи, а Google улучшит позиции в выдаче. Вопреки заявлениям самого Гугла, наличие ключей в URL — значимая информация. В целом за 15 лет многие оптимизаторы уже убедились в этом на собственном опыте. Теперь у нас есть официальное подтверждение.

«Белые списки» сайтов

Также стало известно, что Google формирует так называемые «белые списки» веб-ресурсов, которые получают преимущество в поисковой выдаче. Сайты, не вошедшие в эти списки, наоборот, теряют в рейтинге, что затрудняет их поиск по определенным запросам. Фишкин указывает, что такие списки были задействованы по меньшей мере в двух случаях: во время пандемии и в ходе выборов в США. Тогда поисковик не показывал сайты, которые могли ввести пользователей в заблуждение или накалить общественное мнение по спорным вопросам.

Влияние PageRank главной страницы на остальные

Для каждого документа учитывается PageRank главной страницы сайта. Скорее всего, это нужно на период, пока новая страница не получила собственный PageRank.

Заключительные мысли

Итак, что мы можем почерпнуть для себя из 2500 страниц слитых документов:

- Сильный бренд и доверие пользователей превыше всего. Развивайте не только сайт, но и соцсети, используйте все способы продвижения, собирайте вокруг себя лояльных клиентов.

- Авторитет домена первичен. Самый качественный контент не поднимется в выдаче, если Google не доверяет домену.

- Поведенческие факторы крайне важны, как бы представители Google не утверждали обратное.

- Пользовательский интент важнее, чем тщательный подбор ключевых слов. Чтобы продвигаться в Гугл, нужно решать проблему пользователя.

- Нужно учитывать гео сайта. У поисковика разное количество данных о поведении аудитории в разных странах, поэтому особенности ранжирования могут меняться.